Dimensionality Reduction

Based on the lecture “Intro. to Machine Learning (2023-2)” by Prof. Je Hyuk Lee, Dept. of Data Science, The Grad. School, Kookmin Univ.

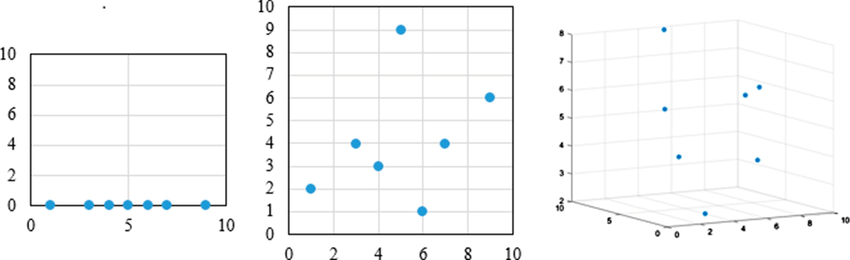

Curse of Dimensionality

-

차원의 저주(Curse of Dimensionality) : 고차원일수록 관측치 간 거리가 기하급수적으로 멀어짐에 따라 차원별 학습 가능한 관측치가 희소해져서 알고리즘이 제대로 학습하지 못하는 현상

-

차원 축소의 당위성

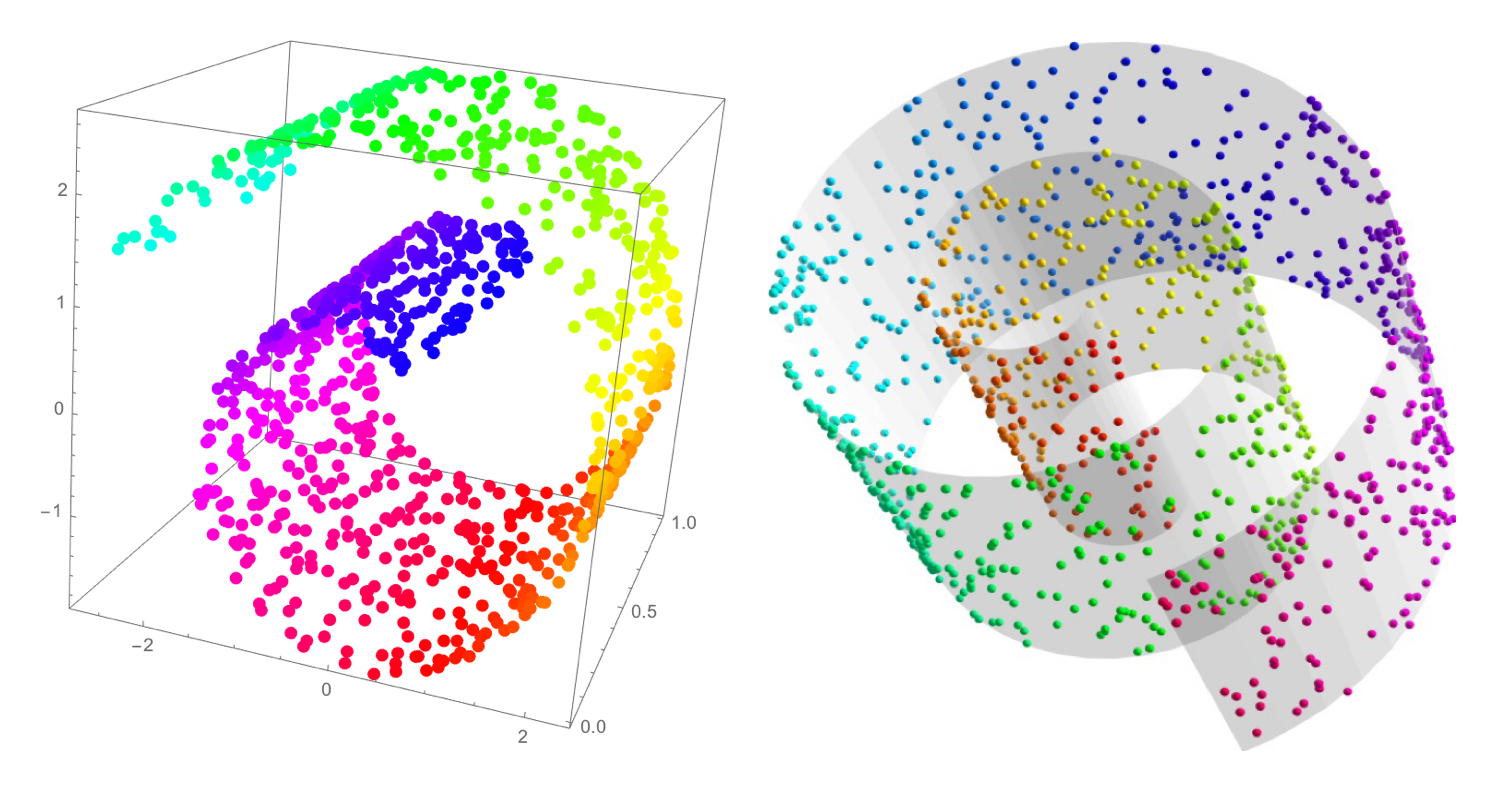

Manifold hypothesis

Many high-dimensional data sets that occur in the real world actually lie along low-dimensional latent manifolds inside that high-dimensional space.

Dimensionality Reduction Methods

- 차원 선택(Feature Selection) : 유효한 차원을 선별하는 방법

-

Filter Approach

-

Wrapper Approach

- Forward Selection

- Backward Elimination

- Stepwise Selection

-

- 차원 추출(Feature Extraction) : 원본의 특징을 보존하는 새로운 차원을 추출하는 방법

- $\text{arg} \max_{\mathbf{w}}{\sigma^{2}}$

- 주성분 분석(

PrincipleComponentAnalysis; PCA) - 선형 판별 분석(

LinearDiscriminantAnalysis; LDA)

- 주성분 분석(

- $\text{arg} \max_{\mathbf{w}}{\text{dist}}$

- 다차원 척도법(

Multi-DimensionalScaling; MDS)

- 다차원 척도법(

- Reveal Non-Linear Structure

- t-SNE(

t-distributedStochasticNeighborEmbedding) - LLE(

LocallyLinearEmbedding) - ISOMAP(

ISOmetric featureMAPping)

- t-SNE(

- $\text{arg} \max_{\mathbf{w}}{\sigma^{2}}$

This post is licensed under

CC BY 4.0

by the author.